Las herramientas de IA generativa no solo han abierto nuevas posibilidades de automatización y productividad, sino que los riesgos e implicaciones éticas se han diversificado desde su creación.

Los sistemas de IA han sido acusados (entre muchas cosas) de manipular elecciones en redes sociales, producir sesgos humanos en la toma de decisiones algorítmicas y aumentar la huella ecológica. de acuerdo a Stamboliev y Christianens (2025); también se les ha denominado como armas de destrucción matemática, ya que, según O’Neil (2016), los algoritmos pueden tener un impacto negativo para la sociedad.

Y aunque existen más de 80 marcos de referencia sobre la ética de la IA, (lo cual nos da un indicador de que no existen principios universales y estáticos sobre este tema), el tiempo y el uso de estos sistemas revelan nuevas implicaciones éticas, así como riesgos asociados a los principios ya conocidos. Todo esto exigirá nuevas regulaciones que den solución a los problemas establecidos y los que están por venir.

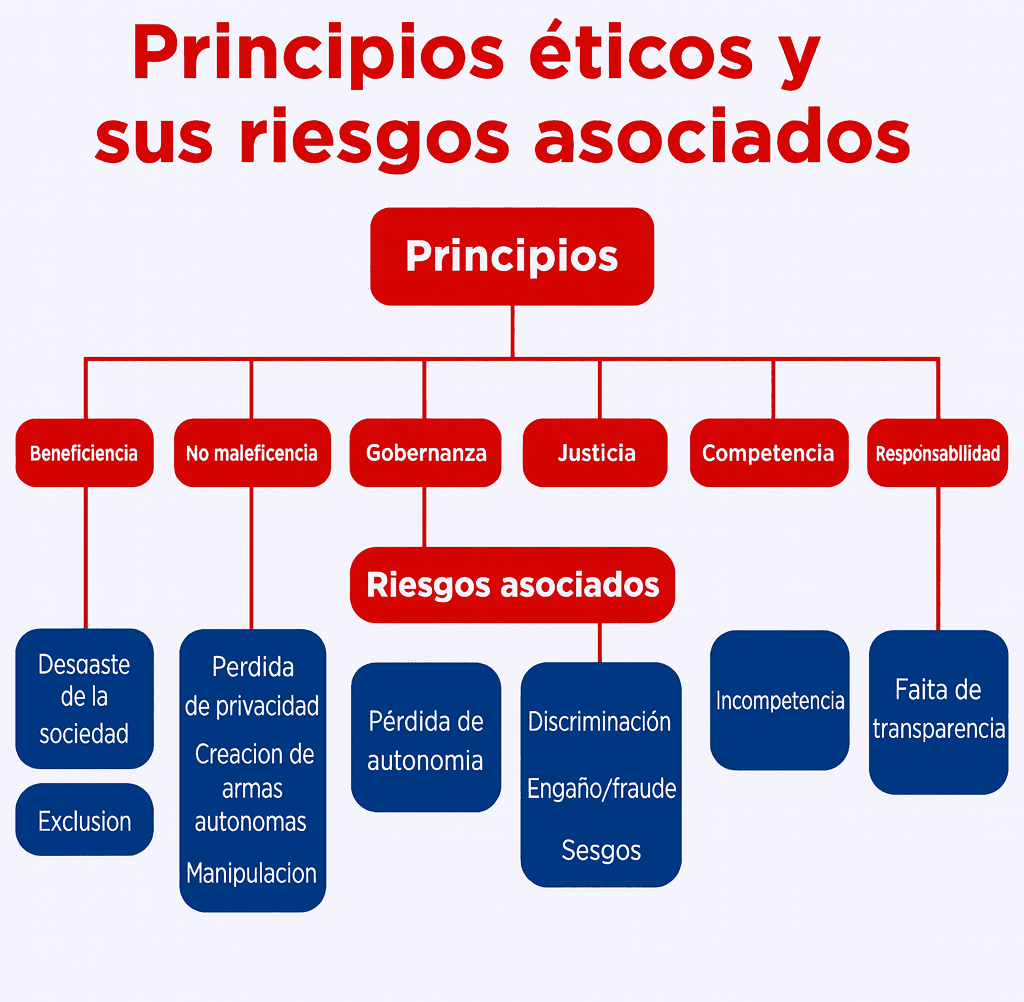

Por esta razón, es crucial hacer una recapitulación para entender los nuevos paradigmas éticos que se vislumbran gracias al uso de la IA generativa, por lo que es necesario recordar los principios éticos clave y los riesgos asociados a estos para comprender los cambios en el discurso ético actual. Para este fin, se utilizarán los principios que las Naciones Unidas establecieron en su reporte “A Framework for Ethical AI at the United Nations”, el cual ha sido también parte del debate entre expertos en el tema.

Cambios en la terminología para describir la ética de la IA

Los principios establecidos por las Naciones Unidas: beneficencia, no maleficencia, gobernanza, justicia, competencia y responsabilidad, son de los términos más conocidos y generales de la ética de la IA. Sin embargo, este, como muchos marcos, datan de un pre-inicio de la IA generativa (ChatGPT fue lanzado en 2022; Gemini y Grok en 2023, por poner algunos ejemplos), por lo que el discurso ha tenido cambios significativos.

En el artículo “Mapping the Ethics of Generative AI: A Comprehensive Scoping Review”, Hagendorff (2024) hace un compendio de revisiones exploratorias que recabaron algunos de los principios éticos recurrentes para el desarrollo y uso de la IA. Estos términos, aunque no pertenecen a un solo marco, han sido las palabras clave reiteradas en estas revisiones para definir la ética de la IA: transparencia, equidad, seguridad, protección, responsabilidad, privacidad y beneficencia.

Entonces, ¿cuáles son los nuevos riesgos/implicaciones que presenta el uso de la IA generativa?

La ética de la IA no puede ser un área estática, ya que conforme pasa el tiempo, existen nuevas herramientas o actualizaciones que exigen nuevos marcos éticos y regulaciones para proteger a los usuarios de los riesgos existentes y futuros que estos sistemas puedan ocasionar.

En este sentido, gracias al uso excesivo de herramientas de IA generativa han surgido nuevas preocupaciones y riesgos éticos, los cuales explicaremos a continuación.

Cibercrimen y jailbreaking

La ciberseguridad se encarga de investigar el uso indebido de la IA generativa para realizar actividades ilícitas. Por tanto, debe proteger equipos, redes, aplicaciones de software y datos de posibles amenazas digitales, con el fin de mantener la confianza de los usuarios y cumplir las normas establecidas.

Algunos ejemplos de cibercrimen son la ingeniería social (uso de IA generativa para la suplantación de identidad), la creación de identidades falsas, la clonación de voz, pishing, así como el uso de los LLM para generar código malicioso y/o para hackear. Según IBM, los hackers utilizan chatbots, ya que son muy susceptibles a la manipulación.

Un ejemplo muy puntual de cibercrimen es el jailbreaking, también conocido como AI jailbreaks, es cuando los hackers explotan las vulnerabilidades de los sistemas de IA para evitar sus directrices éticas, con el objetivo de realizar acciones que son prohibidas o restringidas. Estos ataques suelen dirigirse a los LLM (Large Language Models) y a los modelos de IA generativa.

Alucinaciones y contenido dañino

Los LLM como ChatGPT, Gemini, Grok, Claude, DeepSeek, etc., son sistemas de IA que ayudan a automatizar tareas, generar texto, código, entre muchas otras funciones. Expertos mencionan que se deben validar y verificar sus resultados (outputs) manualmente para asegurar su confiabilidad y veracidad, puesto que han surgido nuevos riesgos asociados con su uso, tales como la generación de contenido falso o inventado (alucinaciones), información engañosa, código erróneo, referencias fabricadas (que muchas veces no existen o tiene información inexistente), creación intencional de desinformación, noticias falsas, propaganda o deepfakes.

Las buenas prácticas, como la verificación de contenido, revisar que las fuentes existan y sean de fuentes confiables, etc., son necesarias y fundamentales a la hora de utilizar estas herramientas.

Alineación

Otra preocupación referente al uso de la IA es el problema de alineación. Es decir, que los intereses de los sistemas de esta tecnología no se alineen con los valores e intereses humanos. A saber, el principio general de la alineación de la IA consiste en entrenar estos sistemas para que sean útiles, transparentes y no dañinos, con el fin de garantizar que su comportamiento se alinee con los valores humanos y los respete. No obstante, expertos señalan que puede haber una formación engañosa, provocando que los sistemas de IA alteren las evaluaciones y que tengan objetivos ocultos.

Desplazamiento y el futuro laboral

Este concepto tiene implicaciones positivas y negativas, según el cristal con que se mire. Por un lado, expertos señalan que la IA podría impactar negativamente a la economía, ya que podría aumentar las desigualdades socioeconómicas, provocando desplazamiento laboral. Además, esto puede provocar desempleo masivo en diversas áreas económicas (por ejemplo, en la atención al cliente, ingeniería de software, plataformas crowdworking, entre otras).

Por otro lado, el informe sobre el futuro del empleo 2025 del Foro Económico Mundial menciona que se crearán 170 millones de nuevos puestos de trabajo, mientras que 92 millones serán desplazados debido a los avances tecnológicos, el cambio demográfico, así como por cuestiones geopolíticas. Asimismo, se enfatiza el papel de la IA para redefinir de los modelos de negocio, por lo que se espera que un 41 % de los empleadores reduzca su personal a causa de las automatizaciones.

Sostenibilidad

Los sistemas de IA necesitan grandes cantidades de energía eléctrica, agua y recursos (como los metales que se requieren para el hardware), lo cual tiene una huella ambiental considerable. Algunas medidas a considerar para mitigar el daño ambiental son el uso de energías renovables, hardware eficiente, así como cambios en los sistemas de congelación y la forma de entrenar a los sistemas de IA. Otras opciones que han surgido para fomentar la sostenibilidad son los datacenters bajo el agua (que tendrán a su vez otras implicaciones ambientales en el lecho marino) o los propuestos datacenters en la Luna o en el espacio exterior, en donde compañías como Amazon trabajan en patentes y su desarrollo, lo cual también tendrá consecuencias e implicaciones éticas que veremos a futuro.

Derechos de autor y creatividad/arte

Gracias al uso de la IA generativa han salido a relucir problemas relacionados con las normas de derechos de autor, ya que se violan estos derechos y la propiedad intelectual por la recopilación no autorizada de datos para entrenar a las IA (de texto e imagen), así como por la memorización o plagio de contenido protegido por derechos de autor de parte de los sistemas de IA.

Sobre la creatividad, existen preocupaciones sobre los efectos negativos de la IA generativa, como las pérdidas financieras de artistas y empresas por la generación del arte sintético generado por la inteligencia artificial, así como el uso no autorizado y sin compensación (para los autores) que los modelos de IA utilizan para entrenar.

Un caso que enlaza a los derechos de autor y al arte, es el de Estudio Ghibli, en donde la IA utilizó su estilo para generar imágenes, detonando un debate sobre los derechos de autor, la creatividad y la explotación artística. Este no es un caso aislado, ya que existen diversas IA que pueden transformar fotos en estilos artísticos como Los Simpson, Lego, Wallace y Gromit, etcétera.

Riesgos de interacción

Debido al gran auge del uso de la IA, se ha incrementado la interacción con dichos sistemas, ya sea para terapia, consulta, trabajo, etc., por lo que se plantean nuevas implicaciones éticas relacionadas con el aspecto de interacción. Algunas preocupaciones según expertos son los desafíos epistemológicos para distinguir el contenido humano del generado por IA, problemas de antropomorfización (que pueden generar una confianza excesiva con estos sistemas), así como problemas relacionados con los agentes conversacionales que podrían afectar la salud mental o suplantar las relaciones interpersonales, causando una deshumanización en las interacciones. Otro riesgo inminente es que la IA, potencialmente los LLM, puedan manipular el comportamiento humano.

Desarrollos con implicaciones éticas a futuro

Una realidad es que los riesgos éticos seguirán aumentando conforme se siga progresando con los avances en la tecnología, por tanto, no cesarán de aparecer, lo cual es un llamado urgente a que la ética en la IA tenga un desarrollo robusto y transparente. Algunas de las patentes y desarrollos que implicarán riesgos e implicaciones éticas a futuro son las siguientes:

Centros de datos en el espacio (Amazon).

Interfaz para leer la mente (Meta).

Gafas de realidad aumentada con la capacidad de reproducir memorias (Apple).

Biosensores portátiles que interactúan con la piel para monitorear la salud.

Aunque la IA generativa es una herramienta que se desarrolló (y sigue su curso) con “buenas intenciones”, es urgente hacer un llamado a la regulación a nivel mundial sobre su desarrollo, uso e implementación, ya que muchas empresas de big tech y big data no han tomado medidas considerables sobre los riesgos éticos que su producto conlleva, y a muchas no les interesa, puesto que tienen otros intereses (monetarios) en concreto.

No se requieren más de 80 marcos de referencia éticos, lo que realmente se necesita son principios aplicables y universales que se puedan ajustar e implementar a nivel global, para que se cumpla con responsabilidad. Además, es imprescindible la transparencia dentro de la ética de la IA y de las empresas para que realmente se pueda visibilizar lo que estas corporaciones hacen o dejan de hacer.

La ética dentro de la IA siempre será un tema de debate, puesto que las naciones y sus empresas van a tener motivos y razones diferentes para regular o no ciertos aspectos de estos sistemas, sin embargo, es necesario presionar sobre la regulación y legislación de la IA para tener algo de control sobre lo que aparentemente “está controlado”, pero que sabemos que, muchas de las veces, existe un ethics washing de por medio.

Fuente:

Observatorio del Instituto para el Futuro de la Educación. (2024, 23 de abril). Nuevas implicaciones éticas de la IA generativa. Observatorio IFE. https://observatorio.tec.mx/nuevas-implicaciones-eticas-de-la-ia-generativa/